[ad_1]

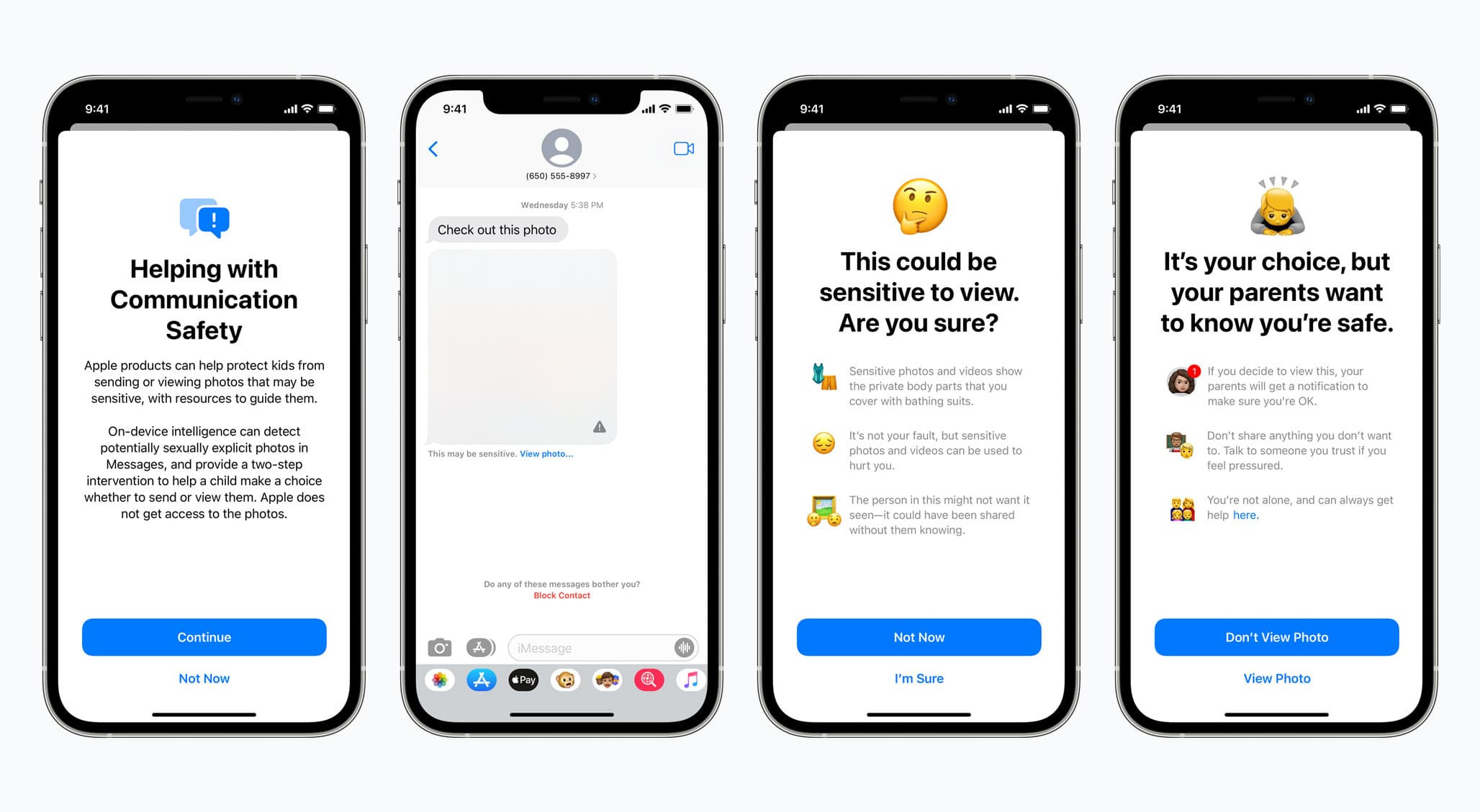

Apple peut faire des vagues avec toutes sortes d’annonces. Prenez par exemple son récent dévoilement de nouvelles protections étendues pour les enfants. Il s’agit d’une suite de fonctionnalités, trois au total, qui visent à protéger les enfants contre les abus et l’exploitation. Il vise également à fournir encore plus d’informations et de ressources à ceux qui pourraient être à risque.

Depuis lors, Apple essaie de dissiper les craintes ou les doutes liés à ces fonctionnalités. Surtout lorsqu’il s’agit de numériser les bibliothèques de photos iCloud, où l’une des nouvelles fonctionnalités recherche du matériel connu d’abus sexuel d’enfants (CSAM). Beaucoup ont dit que cette nouvelle fonctionnalité en particulier pourrait conduire à des efforts moins qu’altruistes de la part de certains groupes et gouvernements.

Mais Apple ne semble pas abandonner l’idée ou sa mise en œuvre. Il a même fourni une FAQ dédiée essayant de purifier l’air. Et apparemment, la société a récemment organisé une session de questions-réponses avec des journalistes (via MacRumeurs) à propos de ces nouvelles fonctionnalités.

C’est au cours de cette session que la société a révélé que l’ajout de la prise en charge d’applications tierces pour ces fonctionnalités de protection de l’enfance était un objectif. La société n’a fourni aucun exemple de ce à quoi cela pourrait ressembler à l’avenir, ni de calendrier pour le moment où cette prise en charge d’applications tierces pourrait se concrétiser.

Cependant, une option potentielle est la fonction de sécurité des communications. Au lancement, cette fonctionnalité permettra à iMessage de détecter lorsqu’un utilisateur iOS/iPadOS/macOS envoie et/ou reçoit des images potentiellement sexuellement explicites via l’application de messagerie. Apple pourrait également déployer la prise en charge d’une application tierce comme Instagram ou d’autres applications de messagerie.

Les applications de stockage de photos qui reposent sur le cloud pourraient également tirer parti de l’outil de détection CSAM.

Selon le rapport d’origine, Apple affirme que toute extension aux applications tierces ne porterait pas atteinte aux protections de sécurité globales ou à la confidentialité des utilisateurs inhérentes à ces fonctionnalités pour les applications/services propriétaires :

Apple n’a pas fourni de délai quant au moment où les fonctionnalités de sécurité pour enfants pourraient être étendues à des tiers, notant qu’elle doit encore terminer les tests et le déploiement des fonctionnalités, et la société a également déclaré qu’elle devrait s’assurer que toute extension potentielle ne serait pas compromettre les propriétés de confidentialité ou l’efficacité des fonctionnalités.

Apple éteint beaucoup d’incendies ici. Ce qui a du sens. Non seulement l’entreprise s’occupe directement de l’exploitation des enfants et des abus sexuels, en essayant de les éliminer, mais elle le fait d’une manière que beaucoup de gens pensent être Big Brother-esque dans sa mise en œuvre de la surveillance.

Il semble qu’Apple essaie de faire en sorte que ces fonctionnalités restent utilisées pour de bon, mais seul le temps nous dira si cela restera le cas dans le futur.

[ad_2]

Poster un Commentaire