[ad_1]

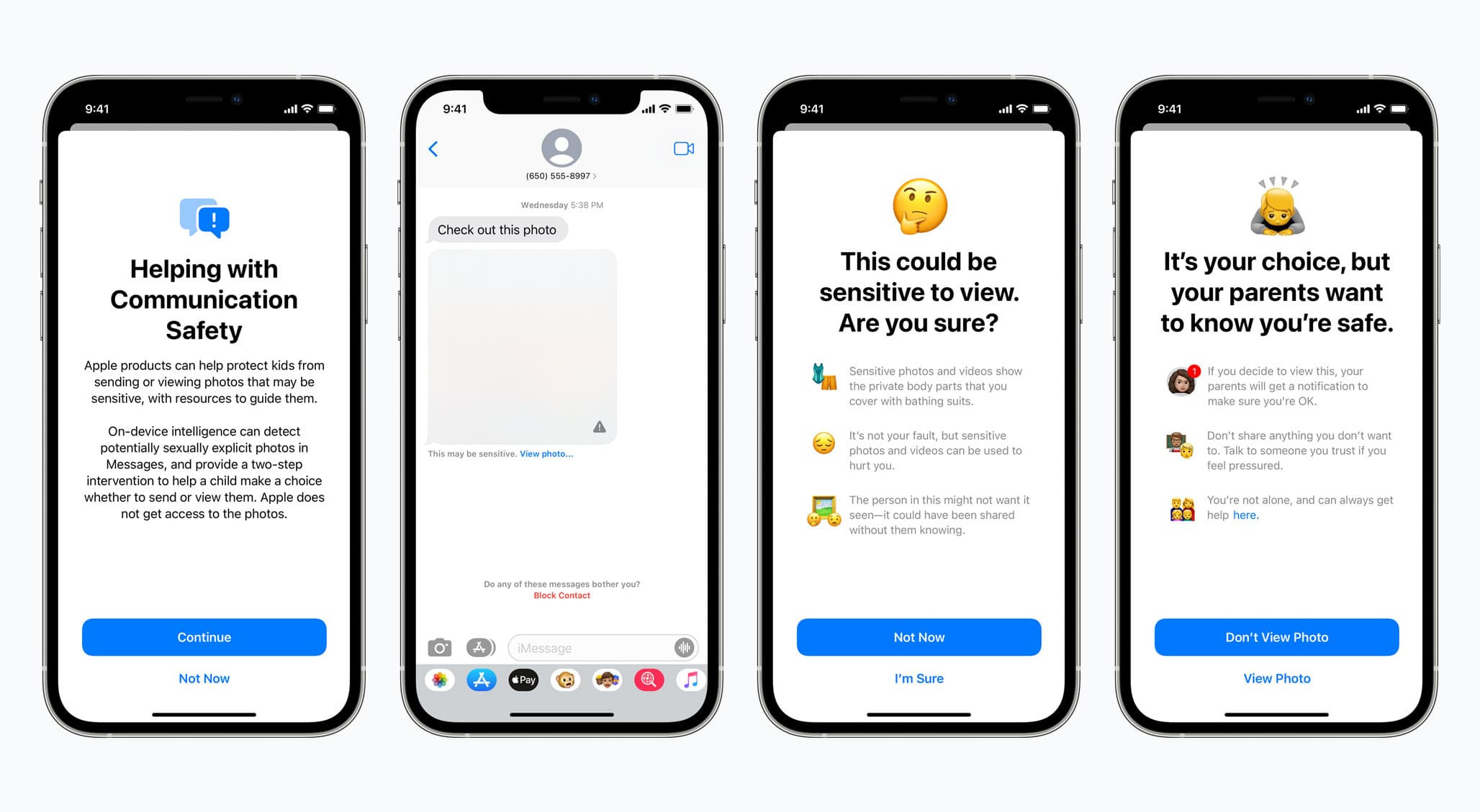

En août, avec le moins de fanfare possible, Apple a annoncé un trio de nouvelles fonctionnalités à venir sur iOS 15, iPadOS 15, macOS 12 Monterey et watchOS 8. Il y en a trois au total, chacune relevant du nouveau de la société, efforts concertés pour aider à protéger contre la maltraitance et l’exploitation sexuelle des enfants. Et bien que les fonctionnalités soient considérées comme une évolution positive en général, en ce qui concerne les spécificités de l’une des nouvelles fonctionnalités, il y a eu beaucoup de recul. Et apparemment ça a marché.

Aujourd’hui, Apple a annoncé qu’il retardait le déploiement de ses fonctionnalités de sécurité pour les enfants. Cela inclut plus d’informations sur l’exploitation sexuelle des enfants, la possibilité de surveiller lorsqu’un jeune envoie ou reçoit des photos potentiellement explicites, et l’outil de détection de matériel d’abus sexuel d’enfants (CSAM) – qui scanne la bibliothèque de photos iCloud des utilisateurs pour rechercher des hachages connus liés directement au CSAM. C’est cette dernière caractéristique qui a suscité la majorité des critiques de la part de ressources et d’agences externes. Certains pensent que c’est une pente glissante, malgré tous les efforts d’Apple pour faire l’éloge des nouvelles fonctionnalités, essayer de montrer comment Apple ou quiconque ne peut en abuser, et sinon essayer de vendre ces nouvelles fonctionnalités comme une bonne chose dans l’ensemble.

Mais, dans un effort pour apaiser ceux qui ont pris ombrage de la ou des nouvelles fonctionnalités, Apple a confirmé qu’il retardait le déploiement pour « prendre plus de temps » pour « apporter des améliorations ». Vous pouvez voir la déclaration complète d’Apple sur le retard ci-dessous.

Déclaration d’Apple :

Le mois dernier, nous avons annoncé des plans pour des fonctionnalités destinées à aider à protéger les enfants contre les prédateurs qui utilisent des outils de communication pour les recruter et les exploiter, et à limiter la propagation du matériel d’abus sexuel d’enfants. Sur la base des commentaires des clients, des groupes de défense des droits, des chercheurs et d’autres, nous avons décidé de prendre plus de temps au cours des prochains mois pour recueillir des commentaires et apporter des améliorations avant de publier ces fonctionnalités de sécurité des enfants d’une importance cruciale.

Comme indiqué dans la déclaration, le plan visant à examiner ces fonctionnalités et à les ajuster si nécessaire prendra un certain temps, Apple se donnant au moins quelques mois pour régler les problèmes. Il n’y a pas de nouveau calendrier pour un lancement, bien sûr, et il va de soi qu’Apple sera probablement encore plus transparent sur ces fonctionnalités à l’avenir. Mais seul le temps nous le dira sur ce front.

En guise de rappel, Apple dit avoir conçu son outil de détection CSAM, qui, encore une fois, analyse une photothèque iCloud à la recherche de hachages connus, en gardant à l’esprit la confidentialité de l’utilisateur final. Voici comment l’entreprise l’a dit lorsqu’elle a initialement annoncé cet élément particulier des nouvelles fonctionnalités de sécurité pour enfants :

La méthode d’Apple pour détecter les CSAM connus est conçue en tenant compte de la confidentialité des utilisateurs. Au lieu de numériser des images dans le cloud, le système effectue une correspondance sur l’appareil à l’aide d’une base de données de hachages d’images CSAM connus fournis par le NCMEC et d’autres organisations de sécurité des enfants. Apple transforme davantage cette base de données en un ensemble illisible de hachages qui est stocké en toute sécurité sur les appareils des utilisateurs.

Avant qu’une image ne soit stockée dans iCloud Photos, un processus de correspondance sur l’appareil est effectué pour cette image par rapport aux hachages CSAM connus. Ce processus de correspondance est alimenté par une technologie cryptographique appelée intersection d’ensembles privés, qui détermine s’il existe une correspondance sans révéler le résultat. L’appareil crée un bon de sécurité cryptographique qui code le résultat de la correspondance ainsi que des données cryptées supplémentaires sur l’image. Ce bon est téléchargé sur iCloud Photos avec l’image.

Alors, que pensez-vous de la décision d’Apple ? Vous pensez que c’est la bonne décision ?

[ad_2]

Poster un Commentaire